Abstract & Introduction

- 作者根据不一致理论,认为“惊喜”是产生幽默的关键因素。

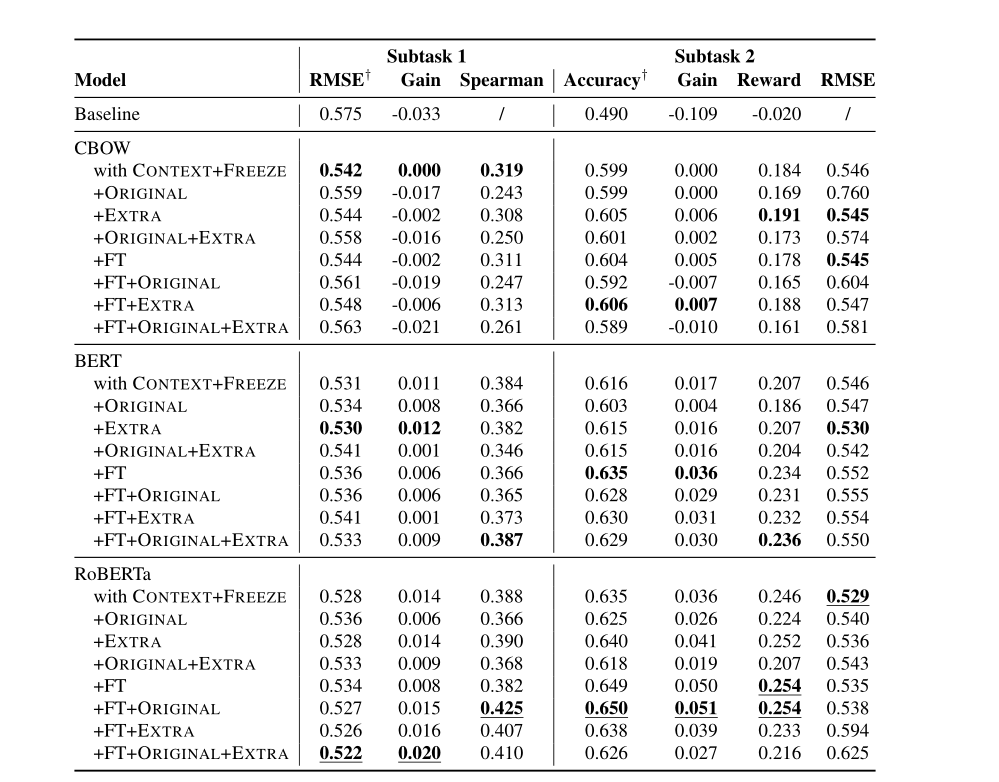

- 作者用了对比的方法(contrastive framework),然后系统比较了三种广泛使用的模型。

- CBOW

- BERT

- RoBERTa

Method & Experiments

不协调理论是幽默的主导理论,它指出“是对不协调事物的感知违反了我们的心理模式和期望”(Morreal,2016)。因此,作者假设,如果编辑词与上下文词或原始词在语义上相距遥远,那么编辑标题就很有趣。

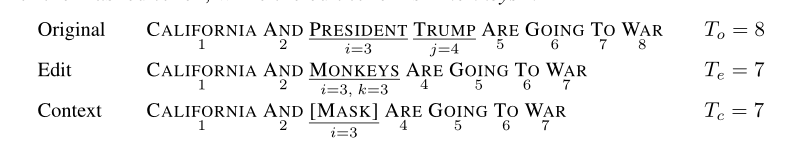

- 如下图,若Edit Sentence是相比于Original Sentence是好笑的,那么edit word和original word或predicted mask token之间的语义相似度就越远。这模拟了对比度和惊喜的强度

“关键词”向量表示:

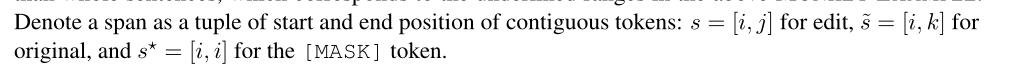

CBOW方法:

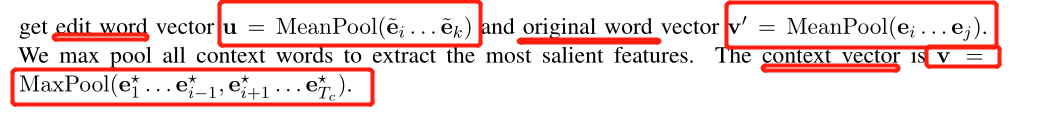

Transformer方法:

Regression-task1

- CONTEXT方法: f(u, v)

- ORIGINAL方法:f(u, v’)

- Classifier:

- not fine-tuning:两层的MLP网络(维度256)

- fine-tuning: 单层线性层

- 损失:均方误差MSE

Classification-task2

同Regression,这里的样本有两条编辑。所以需要分别对这两条编辑后的数据打分,然后判断哪一条更加幽默

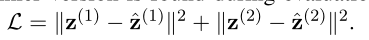

损失:

Emperiments

- Ps: Task2忽略了标签为0的预测