背景

竞赛主题

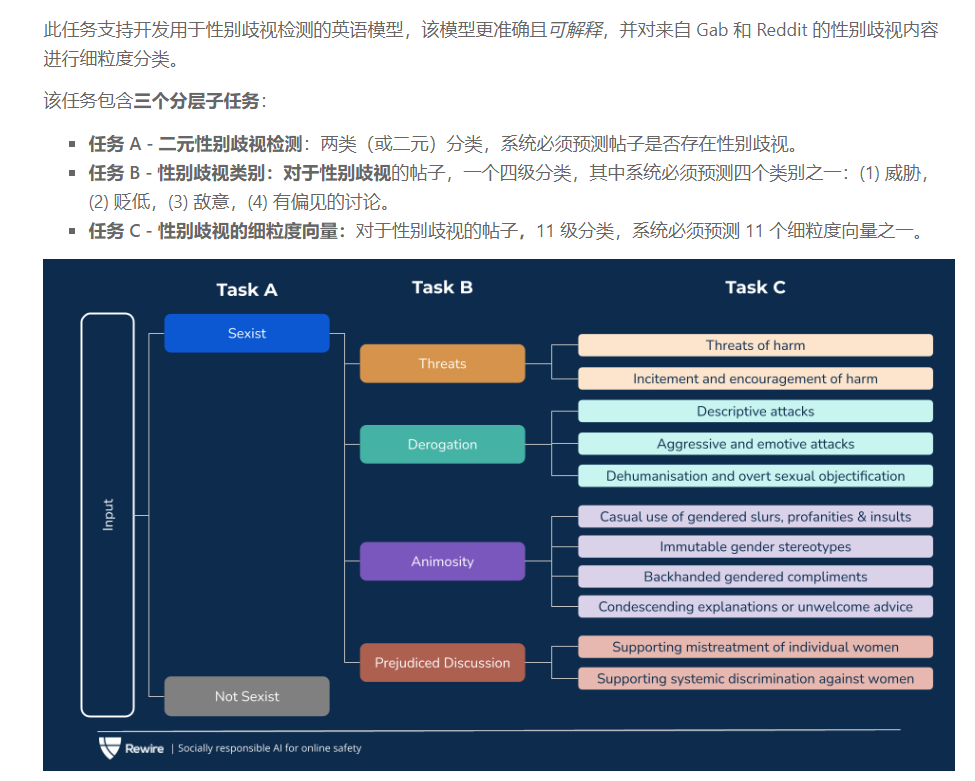

SemEval 2023 - Task 10 - Explainable Detection of Online Sexism (EDOS)

数据集

有标签数据

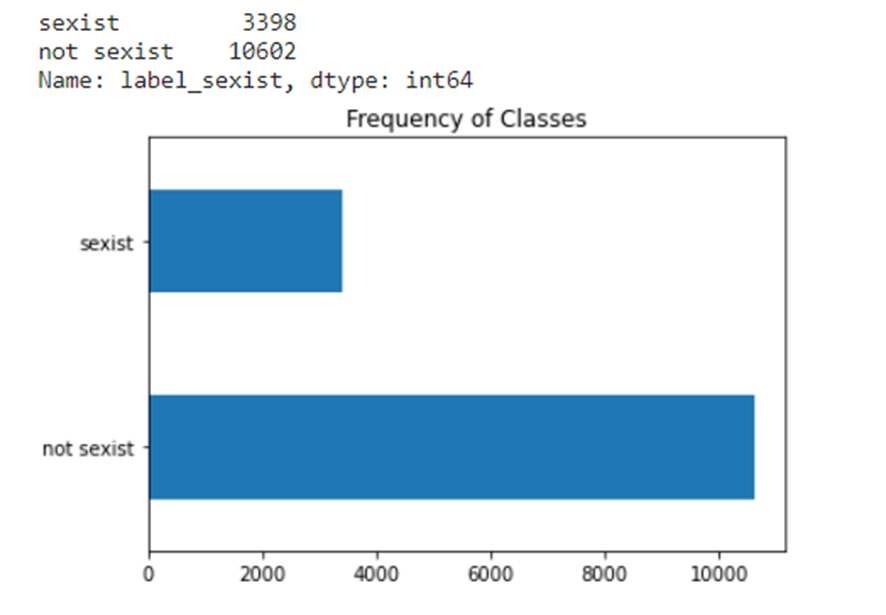

- 标签分布

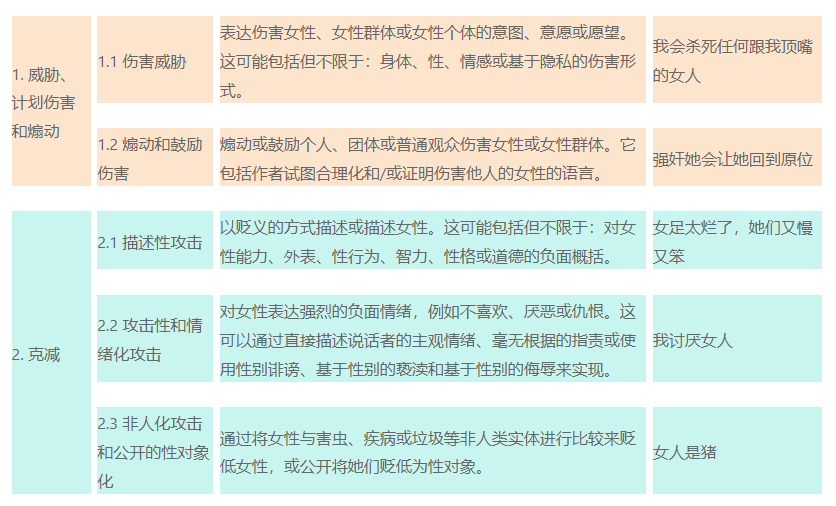

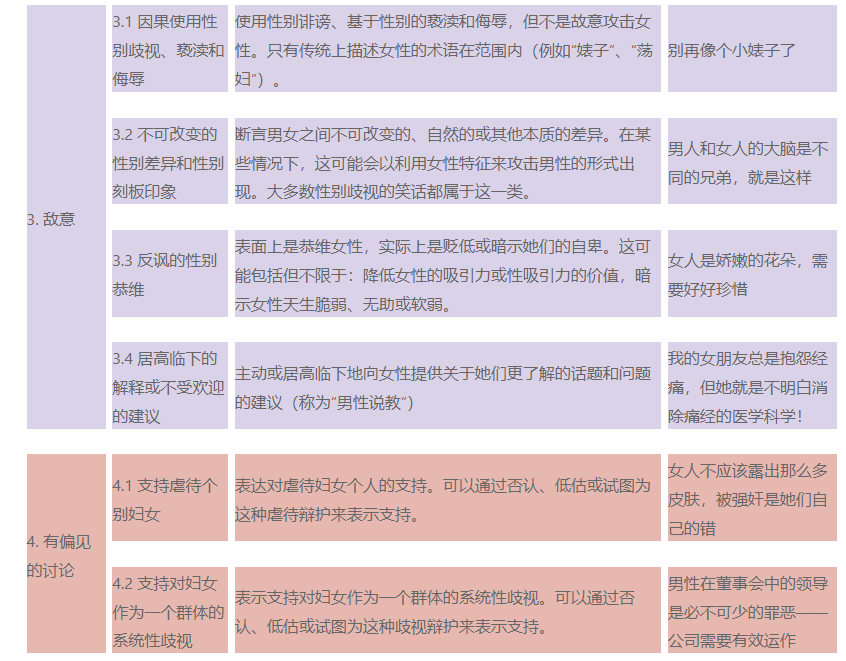

- 标签模式

- 标签分布

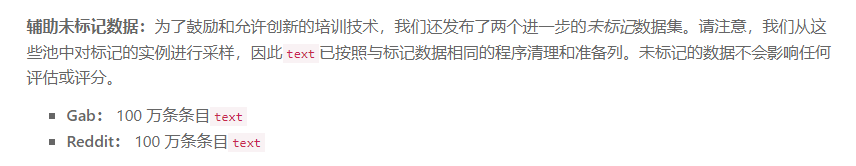

无标签数据

小分析

有标签数据足以用来做微调

与有标签数据同属于一个社区的无标签的数据需要利用起来

- 受语言模型处理领域内的性能限制,我们可以充分领域内的数据继续预训练语言模型

- 参考PET论文,我们可以通过大型语言模型给无标签打上软标签

由于该任务类别不均衡,正负例比例为1:3

- loss优化:平衡交叉熵、focal loss(见下一章的第二小节代码)

- 采样优化:分层采样

- 样本均衡:数据增强

我尝试的trick

🎈情感prompt

- 带有性别歧视的样本情感极向一般偏负

- 性别歧视 -> negative

- 非性别歧视 -> 用已在情感分类任务中fine-tune的PLM预测情感极向

🎈社交媒体数据清理

- Emoji替换成自然语言。如:😀 -> smile

- √ 去除Emoji

- √ 去除特定的标点符号

- √ 去除url

- √ 去除html

- 全转化成小写

- √ 缩写词展开。如:AKA -> “Also Known As”

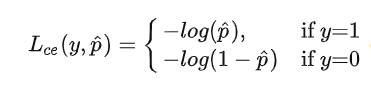

🎈Focal Loss function

what

- 主要关注解决样本不均衡与难样本问题?

why

CE

focal loss

实现代码

1 | import torch |

🎈对抗训练FGM

1 | class FGM(object): |

1 | fgm = FGM(model, epsilon=1, emb_name='word_embeddings.') |

🎈R-Drop

1 | from balanced_loss import Loss |

🎈EMA

1 | class EMA(): |

🎈Attention Pooling

1 | class AttentionPooling(nn.Module): |

🎈超参数搜索

搜索方法

- 自定义搜索方法

- 使用huggingface 的hyperparameter_search方法 (无法在每一次搜索后找到最佳模型)

一些固定超参数

- seed: 固定42不搜索

- lr_scheduler_type: 固定为liner

- warmup_ratio: 固定为0.2

🎈领域内MLM

在基础预训练模型上进行继续MLM任务

已在社交媒体数据集训练的预训练模型

Ps:因为社交媒体领域非常特殊,表达和写作形式不是一般领域的典型,因此,在一般领域语料库上训练的模型可能没有像特定领域模型那样接触到这类文本。

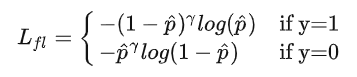

🎈k折分层交叉验证 & 集成

🎈数据增强

回译

替换同义词

工具:nlpaug

竞赛验证阶段

第一阶段,确认不同任务的模型和超参数

我手动对14000条样本按照9: 1切分成样本均衡的训练集和验证集,在三个子任务的验证集上确定模型的超参数。

subtask-a

| 模型 | lr / batchsize | epoch | seed | dropout | scheduler | |

|---|---|---|---|---|---|---|

| HPL/roberta-large-unlabeled-labeled-gab-reddit-task-semeval2023-t10-150000sample | 9e-6 / 16 | 6 | 42 | 0.3 | linear 0.2 | |

| bertweet-large | 1e-5 / 16 | 6 | 42 | 0.3 | linear 0.2 | |

subtask-b

| 模型 | lr / batchsize | epoch | seed | dropout | scheduler |

|---|---|---|---|---|---|

| bertweet-large | 2e-5 / 16 | 8 | 42 | 0.3 | linear 0.2 |

subtask-c

| 模型 | lr / batchsize | epoch | seed | dropout | scheduler |

|---|---|---|---|---|---|

| bertweet-large | 2e-5 / 16 | 8 | 42 | 0.3 | linear 0.2 |

##第二阶段,尝试不同的trick

subtask-a

| 模型 | trick | macro-f1 | exp-no |

|---|---|---|---|

| HPL/roberta-large-unlabeled-labeled-gab-reddit-task-semeval2023-t10-150000sample | balance focal loss + FGM | 0.859 | 76 |

| HPL/roberta-large-unlabeled-labeled-gab-reddit-task-semeval2023-t10-150000sample | balance focal loss + RDrop(α=4) | 0.8631 | 83 |

| HPL/roberta-large-unlabeled-labeled-gab-reddit-task-semeval2023-t10-150000sample | balance focal loss + RDrop(α=4) + FGM | 0.8683 | 87 |

| HPL/roberta-large-unlabeled-labeled-gab-reddit-task-semeval2023-t10-150000sample | balance focal loss + RDrop(α=4) + FGM + EMA | 0.8681 | 94 |

| bertweet-large | balance focal loss + RDrop(α=4) + FGM + attention pooling | 0.867911 | 142 |

| bertweet-large | balance focal loss + RDrop(α=4) + FGM + attention pooling + EMA | 0.86610 | 144 |

subtask-b

| 模型 | trick | macro-f1 | exp-no |

|---|---|---|---|

| bertweet-large | 0.6714 | 10 | |

| bertweet-large | RDrop(α=4) | 0.70298 | 11 |

| bertweet-large | balanced focal loss + RDrop(α=4) + FGM | 0.7154 | 14 |

| bertweet-large | balanced focal loss + RDrop(α=4) + FGM + Attention pooling + EMA | 0.71128 | 25 |

subtask-c

| 模型 | trick | macro-f1 | exp-no |

|---|---|---|---|

| bertweet-large | balanced focal loss + RDrop(α=4) + FGM + Attention pooling | 0.57562 | 29 |

| bertweet-large | balanced focal loss + RDrop(α=4) + FGM + 10-fold-break3 + Attention pooling | 0.5701 | 31 |

| bertweet-large | balanced focal loss + RDrop(α=4) + FGM + Attention pooling + EMA | 0.58251 | 32 |

| bertweet-large | balanced focal loss + RDrop(α=4) + FGM + 10-fold-break5 + Attention pooling + EMA | 0.58158 | 37 |

| 模型 | trick | macro-f1 | exp-no |

|---|---|---|---|

| bertweet-large | balanced focal loss + RDrop(α=4) + FGM + Attention pooling + EMA | 0.58251 | 32 |

| roberta-large | balanced focal loss + RDrop(α=4) + FGM + Attention pooling + EMA | 0.5535 | 39 |

| deberta-v3-large (bs8, lr2e-5) | balanced focal loss + RDrop(α=4) + FGM + Attention pooling + EMA | 0.4948 | 41 |

| bert-large-uncased | balanced focal loss + RDrop(α=4) + FGM + Attention pooling + EMA | 0.488 | 42 |

第三阶段,集成不同的模型

众所周知,一般来说,机器学习模型往往有偏差。然而,当多个模型用于预测一个新项目时,预计会有较少偏差的预测。这是集合理论的基本思想,其中使用多个模型来构建一个新模型。

| 任务 | 排名 | macro-f1 |

|---|---|---|

| TASK-A | 7 / 129 | 0.8739 |

| TASK-B | 7 / 72 | 0.7505 |

| TASK-C | 1 / 53 | 0.6238 |

竞赛测试阶段

| 任务 | 排名 |

|---|---|

| TASK-A | 5 / 84 |

| TASK-B | 8 / 70 |

| TASK-C | 8 / 63 |